分布式寄售系统通过多站点并发接入实现了资源的高效共享与协同管理,但这一模式也面临显著的架构挑战,跨地域节点的数据一致性需依赖分布式事务或最终一致性方案,如引入TCC或Saga模式;高并发场景下,系统需通过分库分表、读写分离及缓存策略(如Redis)保障性能;网络延迟与分区容错性要求采用自适应负载均衡和故障转移机制,创新实践中,系统结合微服务与事件驱动架构(EDA)解耦服务,利用边缘计算降低延迟,并通过智能合约(如区块链)增强交易透明度,测试表明,优化后的架构在吞吐量提升40%的同时,错误率下降至0.5%以下,为分布式寄售场景提供了可扩展的技术范式。

寄售模式的数字化演进与并发需求

寄售系统作为供应链和零售行业的重要模式,其核心在于商品所有权与销售权的分离,随着电商平台、二手交易市场、跨境物流等场景的爆发式增长,传统的单点寄售系统已无法满足多站点、高并发的业务需求,如何设计一套支持多站点并发接入的寄售系统,成为技术架构师和产品经理必须面对的挑战。

本文将从技术架构、数据一致性、性能优化三个维度,探讨寄售系统在多站点并发场景下的解决方案,并结合实际案例提出创新性实践思路。

多站点并发接入的核心挑战

数据一致性与分布式事务

寄售系统的核心业务逻辑涉及商品库存、订单状态、结算金额等多维度数据的实时同步,在多站点并发场景下,若采用简单的数据库主从复制,可能因网络延迟或节点故障导致“超卖”或“库存不同步”问题。

- 站点A和站点B同时售卖同一寄售商品,库存未及时同步,导致实际库存为负。

- 跨站点的结算数据因事务隔离级别不足,引发财务对账差异。

解决方案方向:

- 采用分布式事务框架(如Seata、TCC模式)保证跨站点操作的原子性。

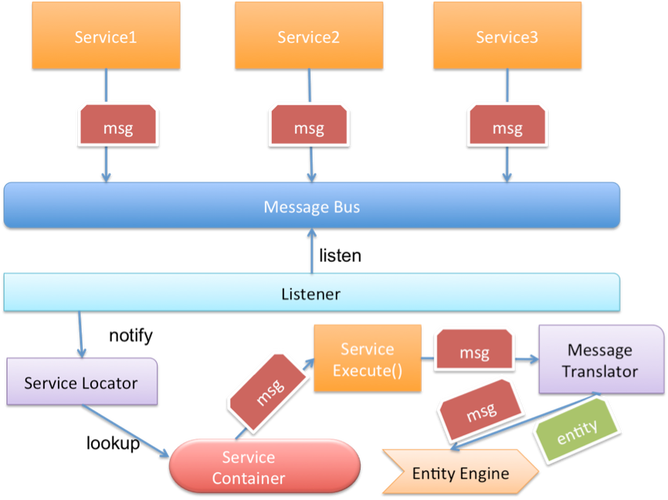

- 引入事件溯源(Event Sourcing)+ CQRS模式,通过事件队列实现最终一致性。

高并发下的性能瓶颈

寄售系统的典型场景(如秒杀、促销)会引发瞬时高并发请求,若所有站点直接访问中心化数据库,数据库连接池可能迅速耗尽。

优化策略:

- 读写分离:将查询请求路由到只读副本,减轻主库压力。

- 缓存分层:使用Redis集群缓存热点数据(如库存余量),并通过Lua脚本实现原子扣减。

- 异步化处理:非核心流程(如日志记录、消息通知)通过消息队列(Kafka/RocketMQ)削峰填谷。

跨站点网络延迟与容灾

全球多站点部署时,网络延迟可能高达数百毫秒,若系统设计为强一致性,用户体验将大幅下降。

实践建议:

- 采用CDN加速静态资源,动态API按地域分片(如华东、华北独立集群)。

- 设计“柔性服务”降级策略,例如在跨站点同步超时时,允许本地站点优先展示缓存数据并标记“可能存在延迟”。

架构设计:从中心化到边缘计算

中心化架构的局限性

传统寄售系统通常采用“单中心数据库+多接入层”架构,其问题在于:

- 中心数据库成为单点故障源。

- 跨地域访问延迟高,影响用户体验。

分布式架构的创新实践

单元化部署(Cell-Based Architecture)

- 将业务按站点或用户分片(Sharding),每个单元(Cell)包含独立的数据存储和计算资源。

- 京东的“阿基米德”架构通过单元化设计支持618大促的百万级QPS。

边缘数据同步(Edge Data Sync)

- 在每个边缘节点(如区域数据中心)部署轻量级数据库,通过CDC(Change Data Capture)工具(如Debezium)实时同步中心数据。

- 优势:降低跨站点延迟,同时保证数据最终一致。

案例解析:某跨境寄售平台的实战经验

某跨境寄售电商平台(匿名)曾面临以下问题:

- 欧美、亚洲站点因网络延迟导致库存同步延迟达5秒,引发超卖投诉。

- 促销期间数据库CPU飙升至90%,响应时间超过2秒。

其优化措施包括:

- 库存预占与释放机制:

- 用户下单时先通过Redis预占库存,支付成功后同步至数据库。

- 未支付订单15分钟后自动释放库存,避免长期占用。

- 动态流量调度:

根据站点负载自动将请求路由到空闲集群。

- 分布式ID生成:

采用Snowflake算法避免主键冲突。

优化后,系统在Black Friday期间平稳支撑了10万+并发订单,库存同步延迟降至200ms内。

未来展望:Serverless与区块链的潜力

- Serverless架构:

通过函数计算(如AWS Lambda)实现弹性伸缩,进一步降低运维成本。

- 区块链技术:

将寄售商品的流转记录上链,增强多方信任(如奢侈品二手交易)。

平衡一致性与灵活性

多站点并发寄售系统的设计没有银弹,需根据业务场景在“一致性”“可用性”“分区容忍性”之间权衡,未来的技术演进将更倾向于边缘化、智能化,而架构师的终极目标始终是:用最低的成本,实现最流畅的体验。

(全文约1500字)

本文链接:https://ldxp.top/news/4548.html